Эксперт по чат-ботам назвал реальную опасность искусственного интеллекта

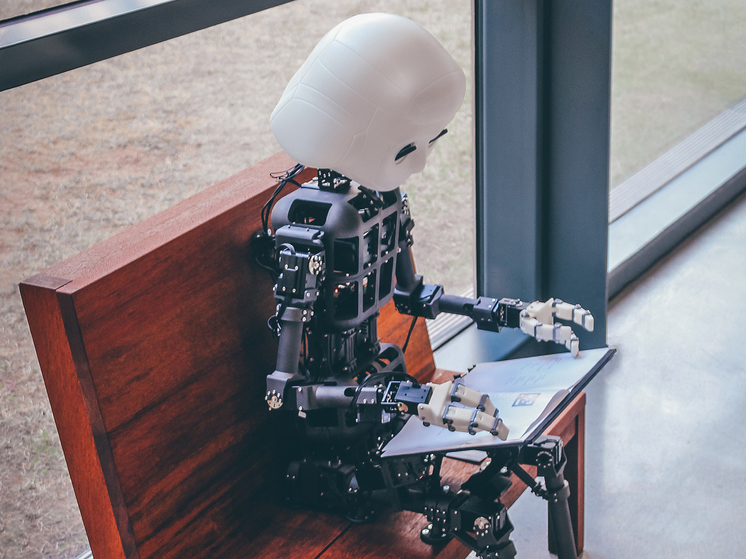

Фото: unsplash.com

По словам высокопоставленного представителя отрасли, участника саммита по безопасности искусственного интеллекта, сосредоточение внимания на сценариях конца света в области искусственного интеллекта отвлекает внимание, преуменьшая непосредственные риски, такие как крупномасштабное распространение дезинформации.

Как пишет The Observer, Эйдан Гомес, соавтор исследовательской работы, которая помогла создать технологию, лежащую в основе чат-ботов, сказал, что долгосрочные риски, такие как экзистенциальные угрозы человечеству со стороны ИИ, следует “изучать и преследовать”, но что они могут отвлечь политиков от решения проблемы непосредственного потенциального вреда.

“Я думаю, что с точки зрения экзистенциального риска и государственной политики это непродуктивный разговор, — утверждает Гомес. – Что касается государственной политики и того, на чем нам следует сосредоточить внимание в государственном секторе — или пытаться снизить риск для гражданского населения, – я думаю, это отвлекает от рисков, которые гораздо более ощутимы и непосредственны”.

Гомес принимает участие в двухдневном саммите, который стартует в среду, в качестве исполнительного директора Cohere, североамериканской компании, производящей инструменты искусственного интеллекта для бизнеса, включая чат-ботов. В 2017 году, в возрасте 20 лет, Гомес работал в команде исследователей Google, которые создали Transformer, ключевую технологию, лежащую в основе больших языковых моделей, которые используют инструменты искусственного интеллекта, такие как чат-боты.

Гомес сказал, что искусственный интеллект – термин, обозначающий компьютерные системы, которые могут выполнять задачи, обычно связанные с разумными существами, – уже широко используется, и именно на этих приложениях следует сосредоточить внимание саммита. Чат-боты, такие как ChatGPT, и генераторы изображений, такие как Midjourney, ошеломили общественность своей способностью создавать правдоподобный текст и изображения из простых текстовых подсказок.

“Эта технология уже используется в миллиарде пользовательских продуктов, таких как Google и другие. Это создает множество новых рисков для обсуждения, ни один из которых не является экзистенциальным, ни один из которых не является сценарием конца света, — сказал Гомес. – Мы должны сосредоточиться непосредственно на тех произведениях, которые вот-вот повлияют на людей или активно влияют на них, в отличие, возможно, от более академических и теоретических дискуссий о долгосрочном будущем”.

Гомес сказал, что дезинформация – распространение вводящей в заблуждение или неверной информации в Интернете – стала его главной заботой. “Дезинформация — это то, что для меня важнее всего, — сказал он. – Эти модели искусственного интеллекта могут создавать медиа, которые являются чрезвычайно убедительными, очень неотразимыми, практически неотличимыми от созданного человеком текста, изображений или медиа-носителей. И это то, чем нам необходимо заняться в срочном порядке. Нам нужно выяснить, как мы собираемся дать общественности возможность различать эти различные типы средств массовой информации ”.

В день открытия саммита пройдут дискуссии по целому ряду вопросов искусственного интеллекта, включая проблемы, связанные с дезинформацией, такие как срыв выборов и эрозия общественного доверия. Во второй день, в котором примет участие небольшая группа стран, экспертов и технических руководителей, созванных Риши Сунаком, будет обсуждаться, какие конкретные шаги можно предпринять для устранения рисков, связанных с искусственным интеллектом. Среди присутствующих ожидается вице-президент США Камала Харрис.

Гомес, который назвал саммит “действительно важным”, говорит, что уже сейчас “очень вероятно”, что армия ботов – программного обеспечения, выполняющего повторяющиеся задачи, такие как размещение сообщений в социальных сетях, – может распространять дезинформацию, сгенерированную искусственным интеллектом. “Если вы можете это сделать, это реальная угроза демократии и общественному обсуждению”, — предупреждает он.

В серии документов, описывающих риски ИИ на прошлой неделе, которые включали дезинформацию, генерируемую ИИ, и сбои на рынке труда, правительство Британии заявило, что не может исключить, что развитие ИИ достигнет точки, когда системы будут угрожать человечеству, отмечает The Observer.

В документе о рисках, опубликованном на днях, говорилось: “Учитывая значительную неопределенность в прогнозировании развития ИИ, нет достаточных доказательств, чтобы исключить, что высокопроизводительные системы пограничного ИИ, при неправильной настройке или неадекватном контроле, могут представлять угрозу существованию”.

В документе добавлялось, что многие эксперты считают такой риск очень низким и что это повлечет за собой реализацию ряда сценариев, включая получение продвинутой системой контроля над оружием или финансовыми рынками. Опасения по поводу экзистенциальной угрозы со стороны ИИ связаны с перспективой так называемого искусственного общего интеллекта — термина для системы ИИ, способной выполнять множество задач на человеческом или сверхчеловеческом уровне интеллекта, – который теоретически может воспроизводить себя, уклоняться от контроля человека и принимать решения, идущие вразрез с человеческими.’ интересы.

Эти опасения привели к публикации в марте открытого письма, подписанного более чем 30 000 технических специалистов и экспертов, включая Илона Маска, призывающего к шестимесячной паузе в гигантских экспериментах с искусственным интеллектом.

Двое из трех современных “крестных отцов” ИИ, Джеффри Хинтон и Йошуа Бенгио, подписали в мае еще одно заявление, предупреждающее, что к предотвращению риска вымирания от ИИ следует относиться так же серьезно, как к угрозе пандемий и ядерной войны. Однако Ян Лекун, их коллега — “крестный отец” и один из лауреатов премии ACM Turing award, которая считается Нобелевской премией в области вычислительной техники, назвал опасения, что искусственный интеллект может уничтожить человечество, “абсурдными”.

Добавить комментарий

Для отправки комментария вам необходимо авторизоваться.